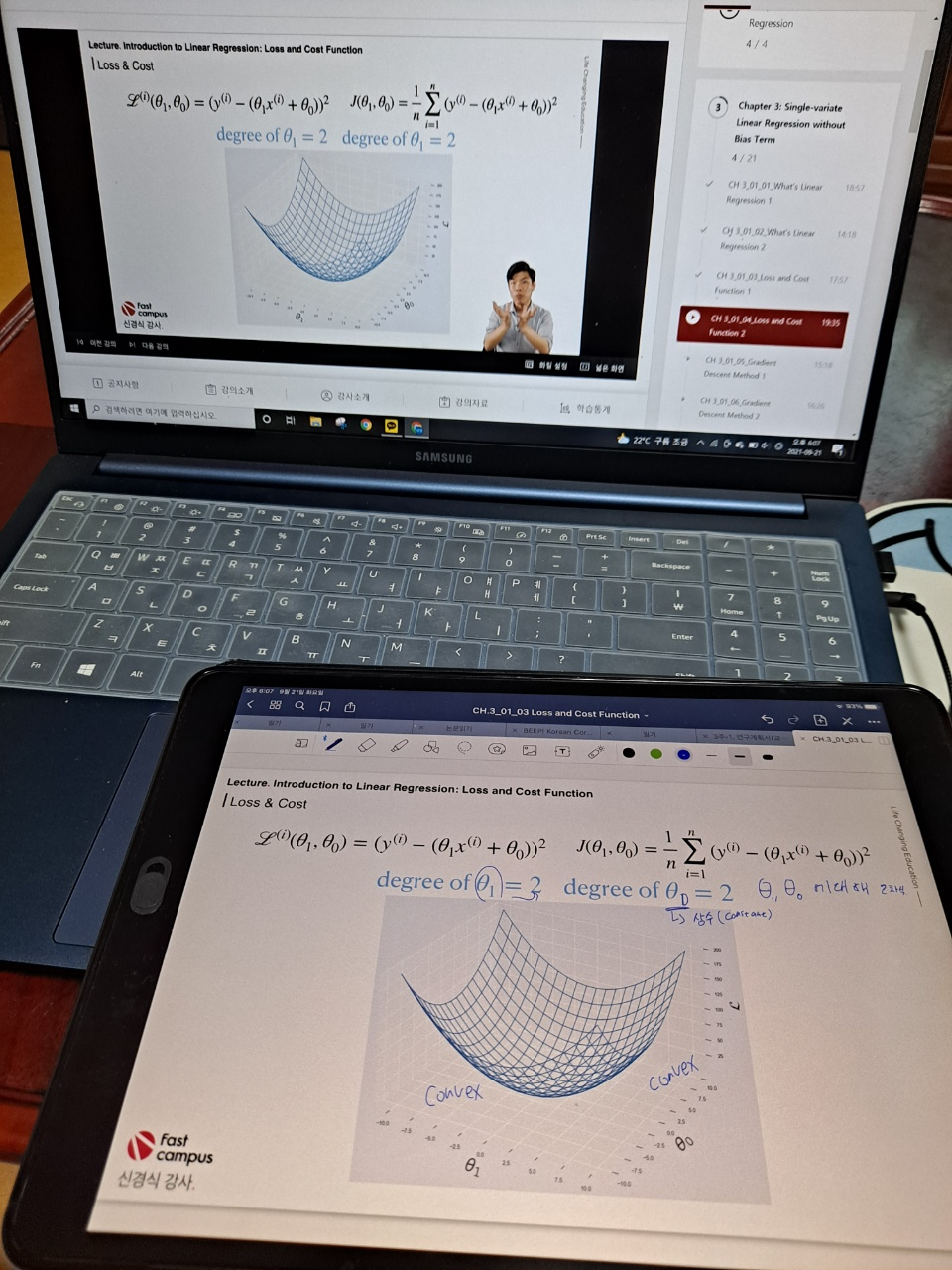

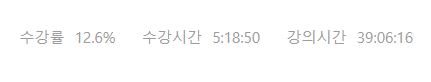

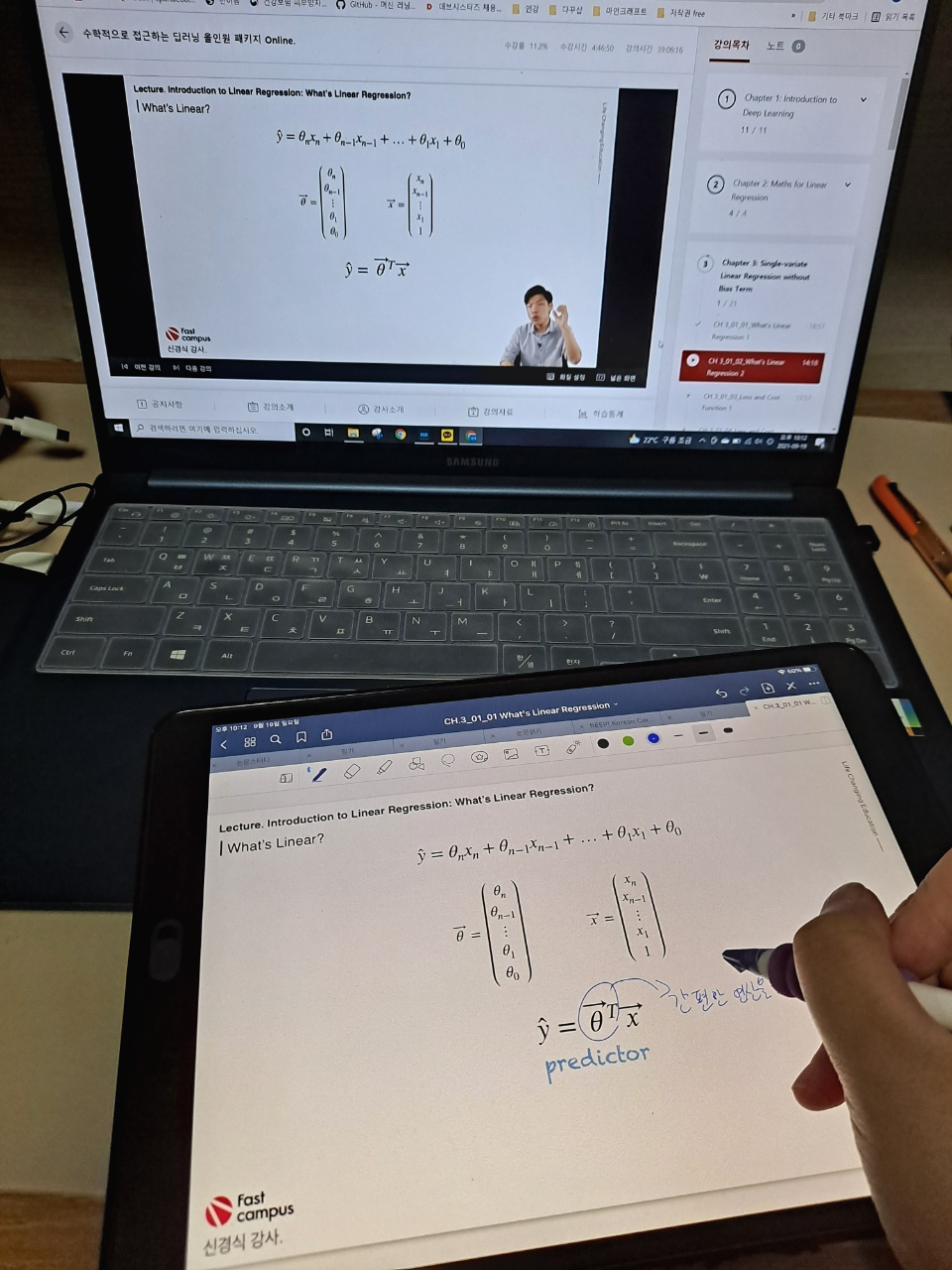

2021. 09. 22 수요일 17일차

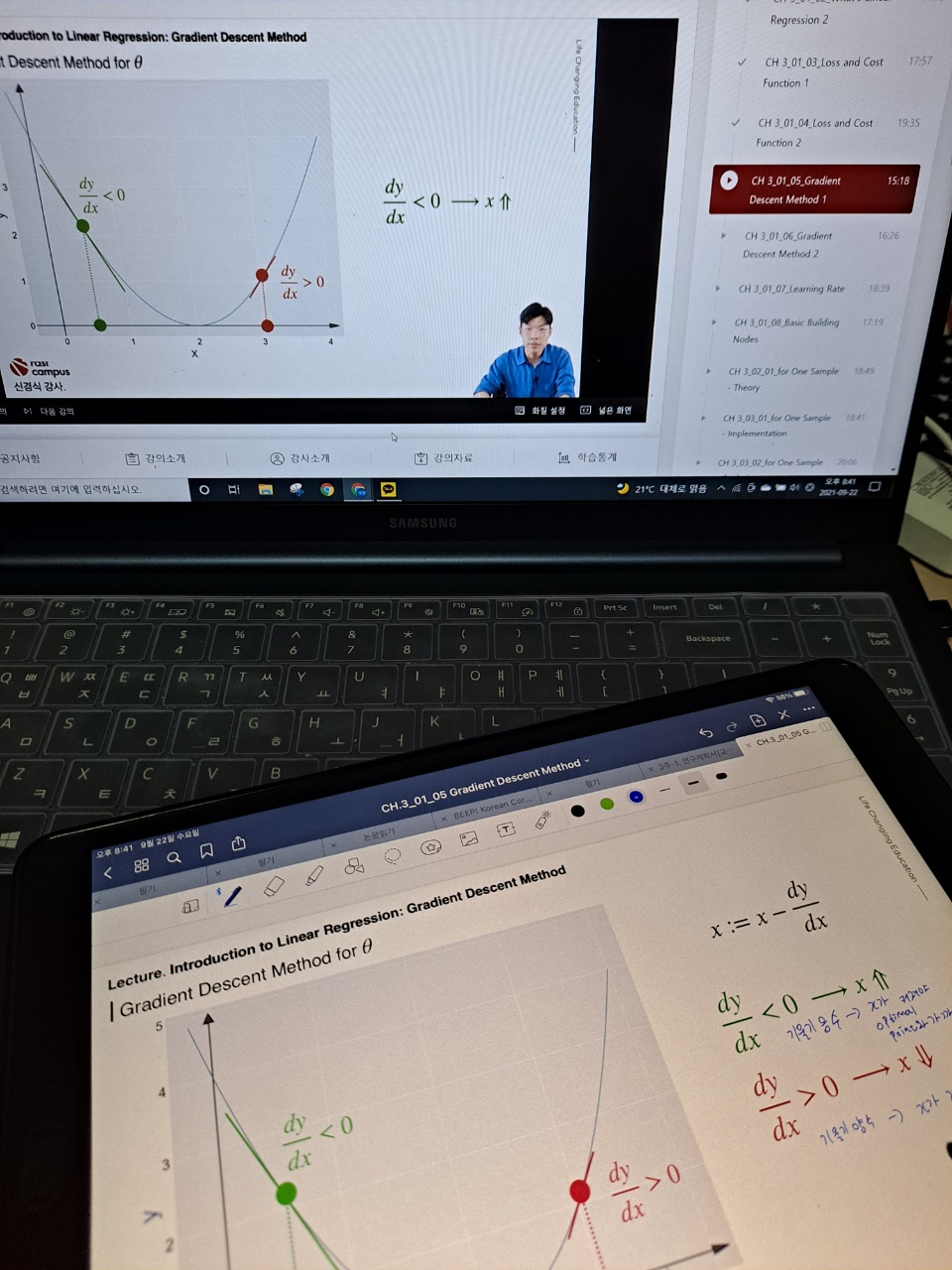

3-1-5 Gradient Descent Method 1

이번 강의는 Gradient Descent Method 를 배웠다.

Gradient 란 구배 라고도 하고 기울기 라고도 하고, 그냥 한글로 읽어서 그래디언트라고도 한다.

Gradient의 의미를 위키백과에서 찾아봤는데, 글로 읽어도 잘 모르겠다.

Gradient: 벡터 미적분학에서 스칼라장의 최대의 증가율을 나타내는 벡터장을

뜻한다. 기울기를 나타내는 벡터장을 화살표로 표시할 때 화살표의 방향은 증가율이 최대가 되는 방향이며, 화살표의 크기는 증가율이 최대일 때의 증가율의 크기를 나타낸다.

출처: 위키백과 (https://ko.wikipedia.org/wiki/%EA%B8%B0%EC%9A%B8%EA%B8%B0_(%EB%B2%A1%ED%84%B0)

정리해보자면 스칼라에서의 '기울기'를 벡터장에서는 Gradient라고 부르는 것 같다. (그냥 나는 그렇게 이해했다..)

Gradient Descent 란 Gradient를 감소시켜 최적점(optimal point)를 찾아가는 방법(method)이다.

Gradient를 감소시킨다는 것은 절댓값 기준으로 보면 이해가 쉽다.

특정 data point에서 -3의 기울기(여기서는 편의상 Gradient를 기울기로 설명하겠다.)를 가졌다면 기울기의 절댓값을 감소시키는 방향으로 x를 움직여본다. 기울기가 -이면 x를 +방향(오른쪽)으로 이동시킨다. 기울기가 +이면 x를 -방향으로 움직인다.

이렇게해서 기울기가 0이되면, 그 point를 최적점(optimal point)라고 한다.

배운 것은 많지만 아직 정리가 되지 않아 글로 설명을 써두지는 못하겠다. (평생소장 강의니까 나중에 또 들어야지 ㅎㅎ)

그동안 그냥 어렴풋이 이해했던 gradient를 이렇게 글로 설명할 수 있을정도로 이해하게 되었다.

진짜 신경식 강사님.. 제 대학원 생활의 은인이십니다..☆

▼패캠 강의 리스트▼

*본 포스팅은 패스트캠퍼스 환급 챌린지 참여를 위해 작성되었습니다.*

#패스트캠퍼스, #패캠챌린지 #직장인인강 #직장인자기계발 #패스트캠퍼스후기 #수학적으로_접근하는_딥러닝_올인원_패키지_Online #대학원생공부 #인공지능독학 #머신러닝 #딥러닝

'인공지능 > 수학' 카테고리의 다른 글

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 19일차 (0) | 2021.09.24 |

|---|---|

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 18일차 (0) | 2021.09.23 |

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 16일차 (0) | 2021.09.21 |

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 15일차 (0) | 2021.09.20 |

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 14일차 (0) | 2021.09.19 |