2021. 09. 23 목요일 18일차

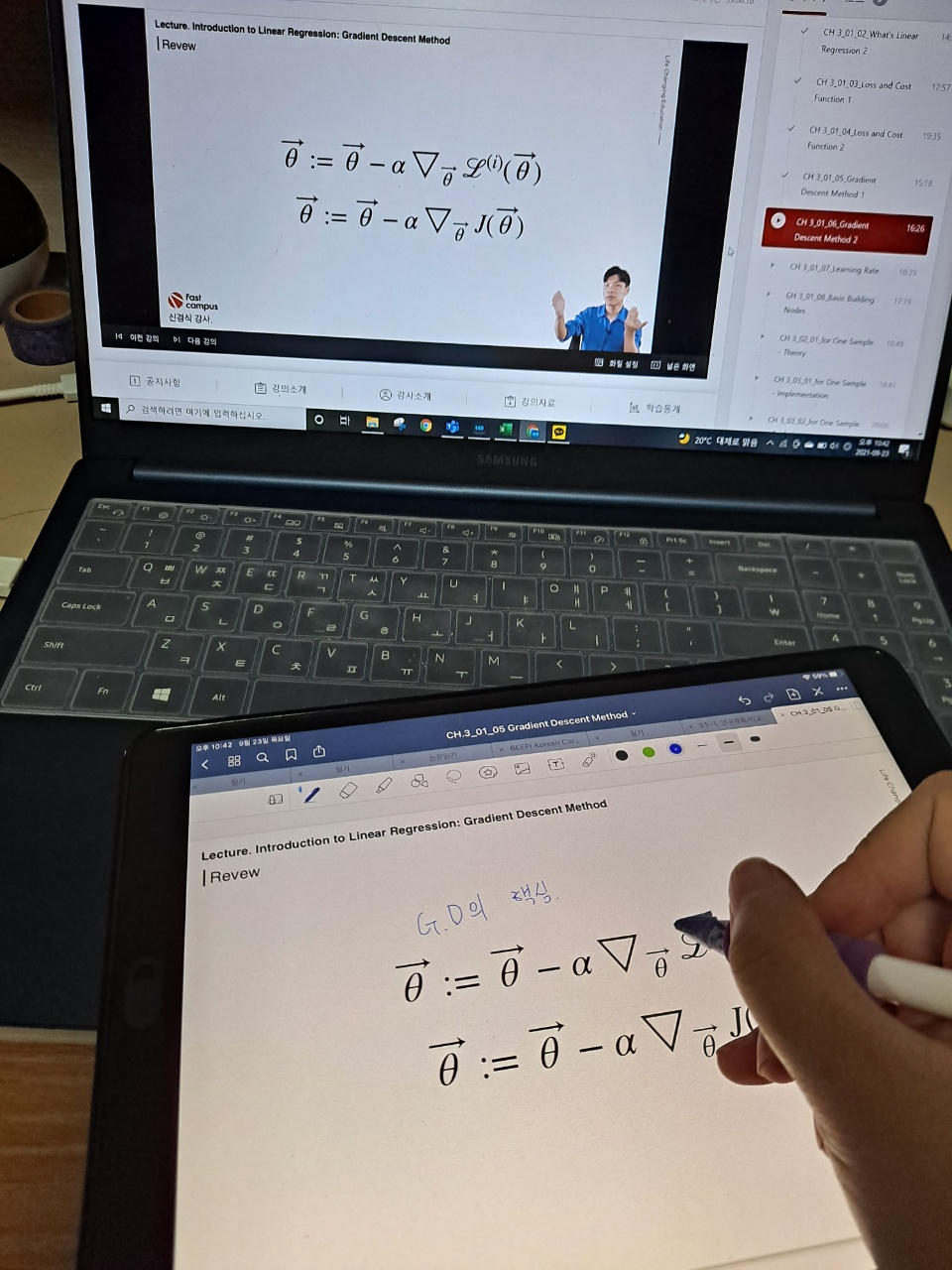

3-1-5 Gradient Descent Method 2

저번 시간에 이어 Gradient Descent Method에 대해 배웠다.

강의 내용을 정리해보자.

loss 함수 그래프가 아래로 볼록한 그래프라고 생각해보자.

이미지를 두고 설명하면 좋을 것 같아 어디선가 퍼온 사진이다.

A점과 B점이 있다하면, 우리는 그 지점의 그래디언트만 알고 있다.

아래로 볼록한 전체 함수의 개형은 모르는 것이다.

그래서 그래디언트를 기반으로 해서 최적점을 찾으려면 어느 방향으로 가야하는지(오른쪽으로 갈지 왼쪽으로 갈지) 그것만 알고 있는 상태인 것이다.

우리는 그 그래디언트로 우리가 만든 모델(ex. y = θ1x1+θ0) 의 파라미터들(θ1,θ0) 을 학습시킨다.

우리가 가진 데이터들을 일반화할 수 있도록 하는 가장 최적의 파라미터가 될 수 있도록 학습시킨다.

그런데 이때, θ1과 θ0의 학습속도가 다를 수 있다. θ0는 느리게 학습하고 θ1은 엄청 빠르게 학습을 하면 같은 학습을 했을 때 어떤건 최적이 아닐 수 있게 된다.

그리고 파라미터를 예시에서는 2개로 두었지만, 실제 문제에서는 10개, 20개, n개 만큼 둘 수 있으므로 파라미터들의 학습 속도가 모두 다르면 학습 속도 차이 때문에 학습이 잘 안 될 수 있다.

따라서 파라미터는 자신의 bias가 전체 cost에 얼마나 영향을 주었는지만 편미분으로 계산하여 업데이트한다.

즉, 파라미터는 각각 업데이트된다.

▼패캠 강의 리스트▼

*본 포스팅은 패스트캠퍼스 환급 챌린지 참여를 위해 작성되었습니다.*

#패스트캠퍼스, #패캠챌린지 #직장인인강 #직장인자기계발 #패스트캠퍼스후기 #수학적으로_접근하는_딥러닝_올인원_패키지_Online #대학원생공부 #인공지능독학 #머신러닝 #딥러닝

'인공지능 > 수학' 카테고리의 다른 글

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 20일차 (0) | 2021.09.25 |

|---|---|

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 19일차 (0) | 2021.09.24 |

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 17일차 (0) | 2021.09.22 |

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 16일차 (0) | 2021.09.21 |

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 15일차 (0) | 2021.09.20 |