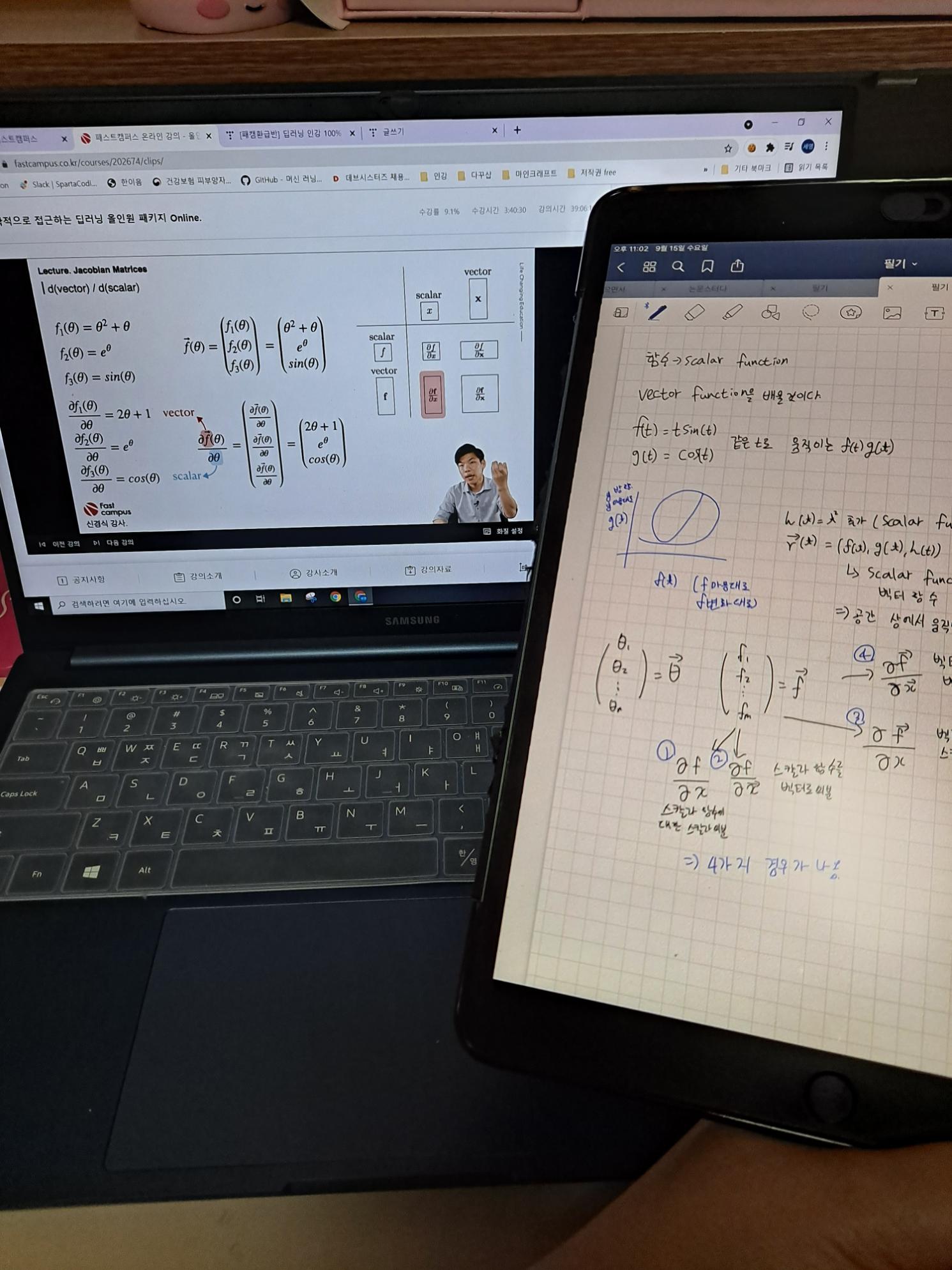

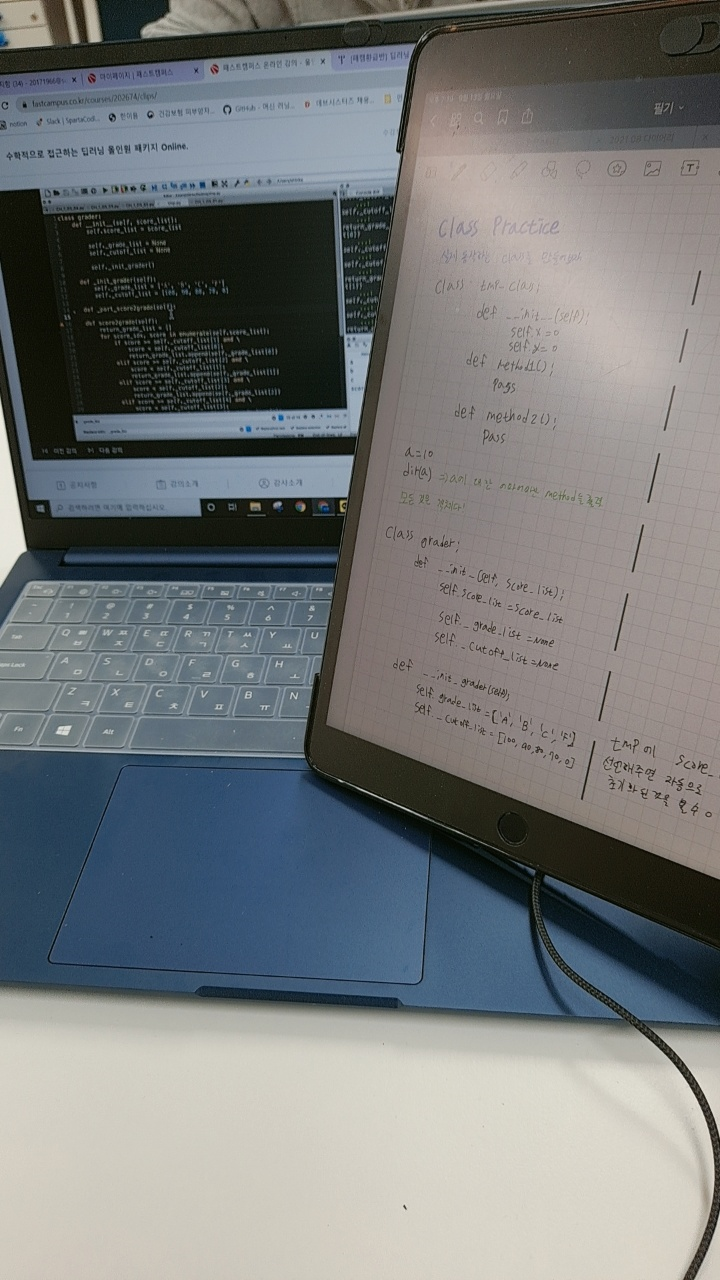

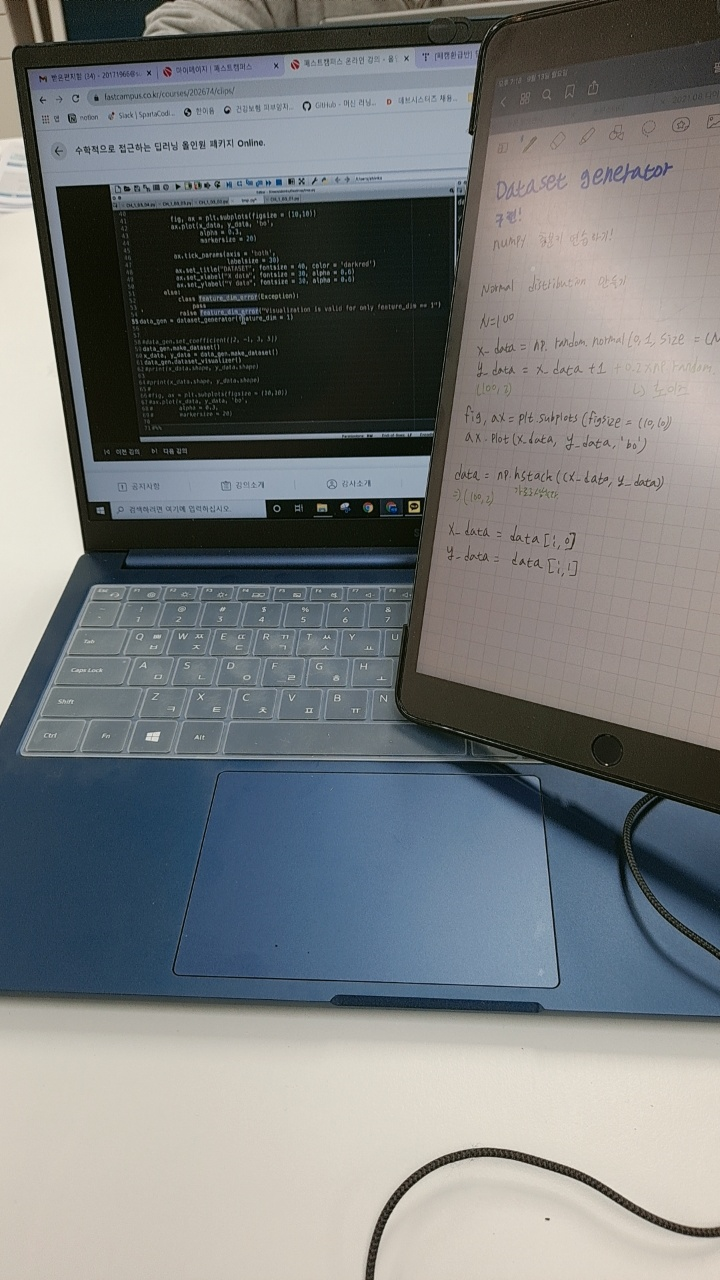

2021. 09. 20 월요일 15일차

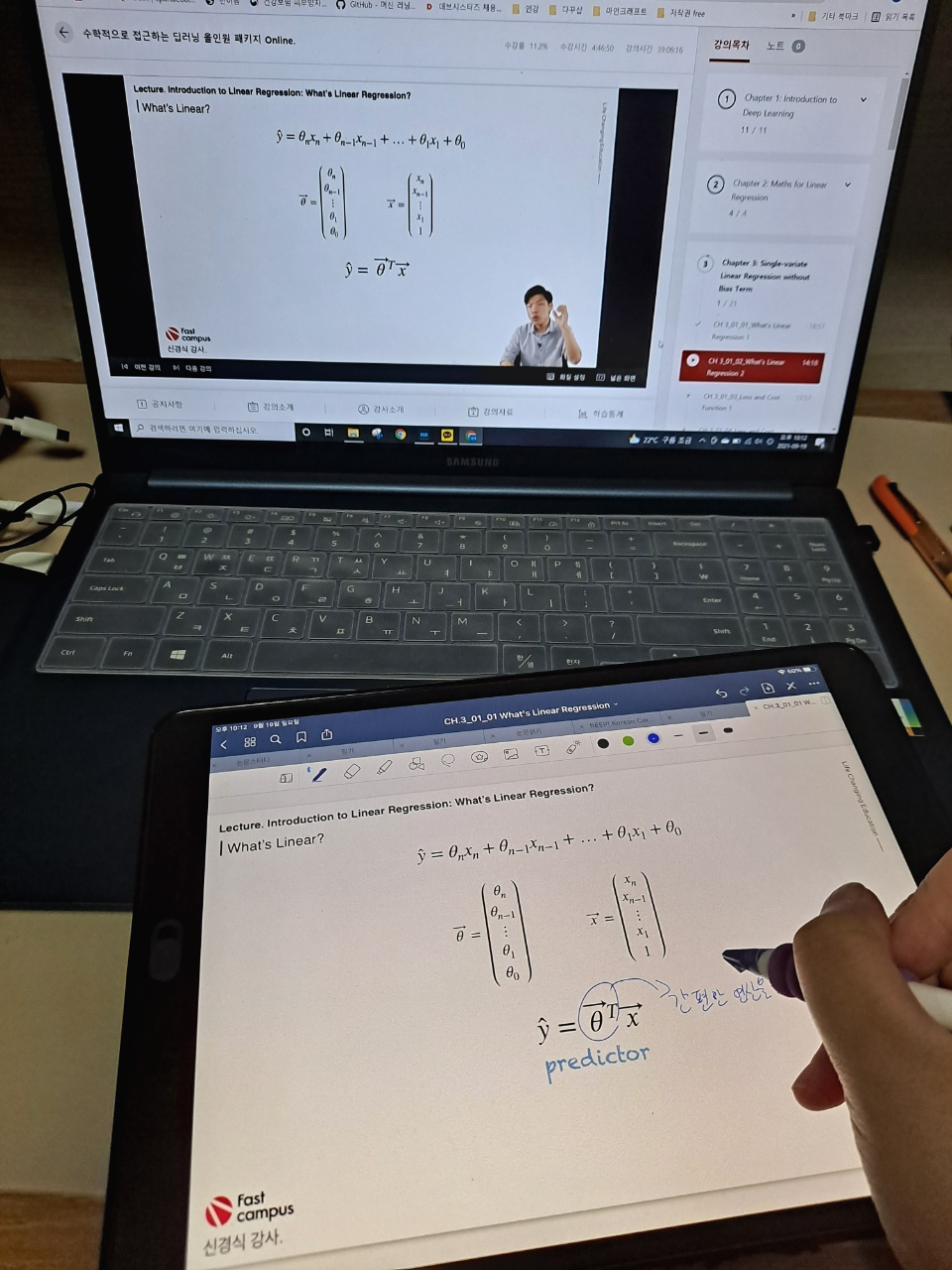

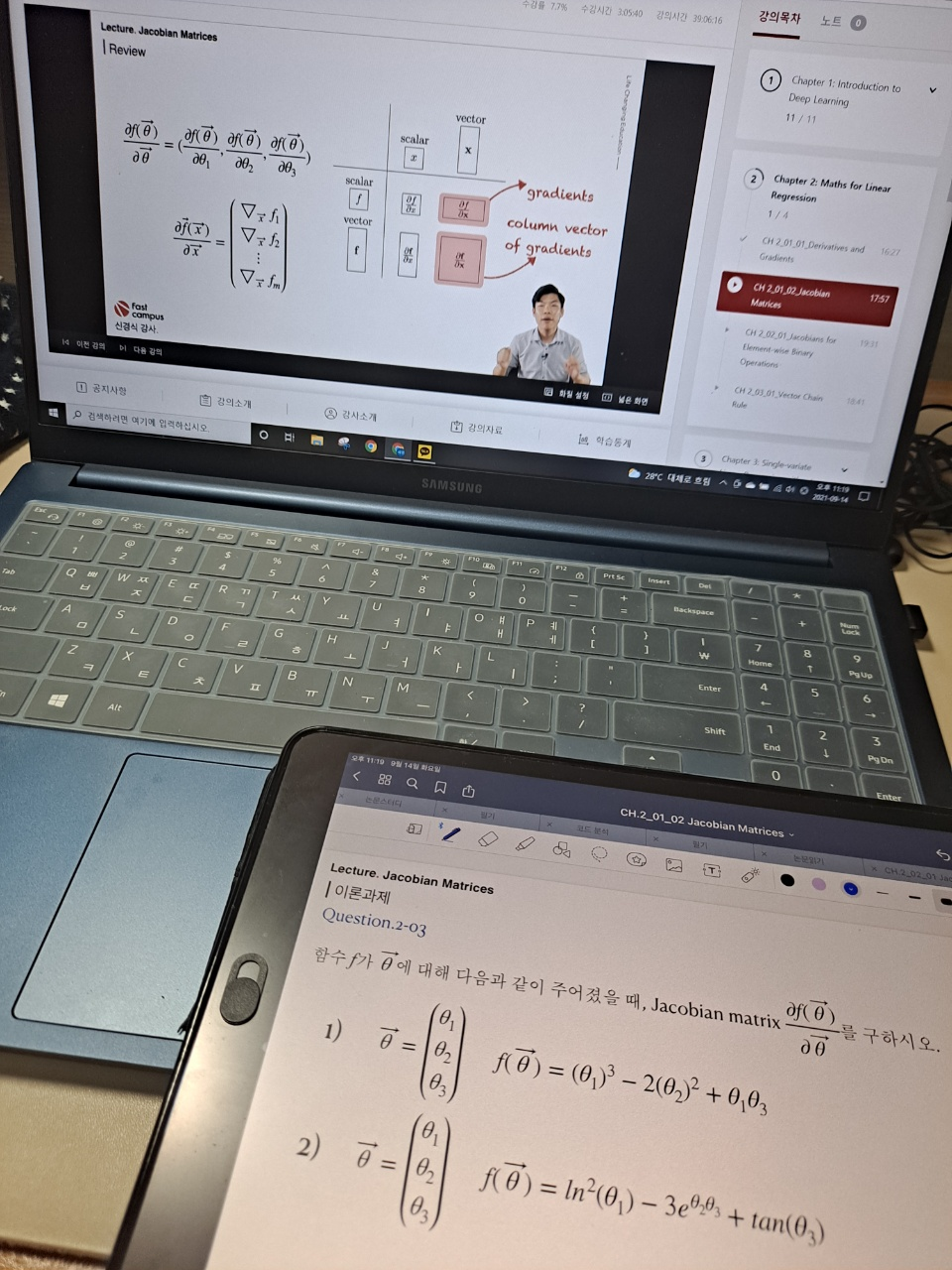

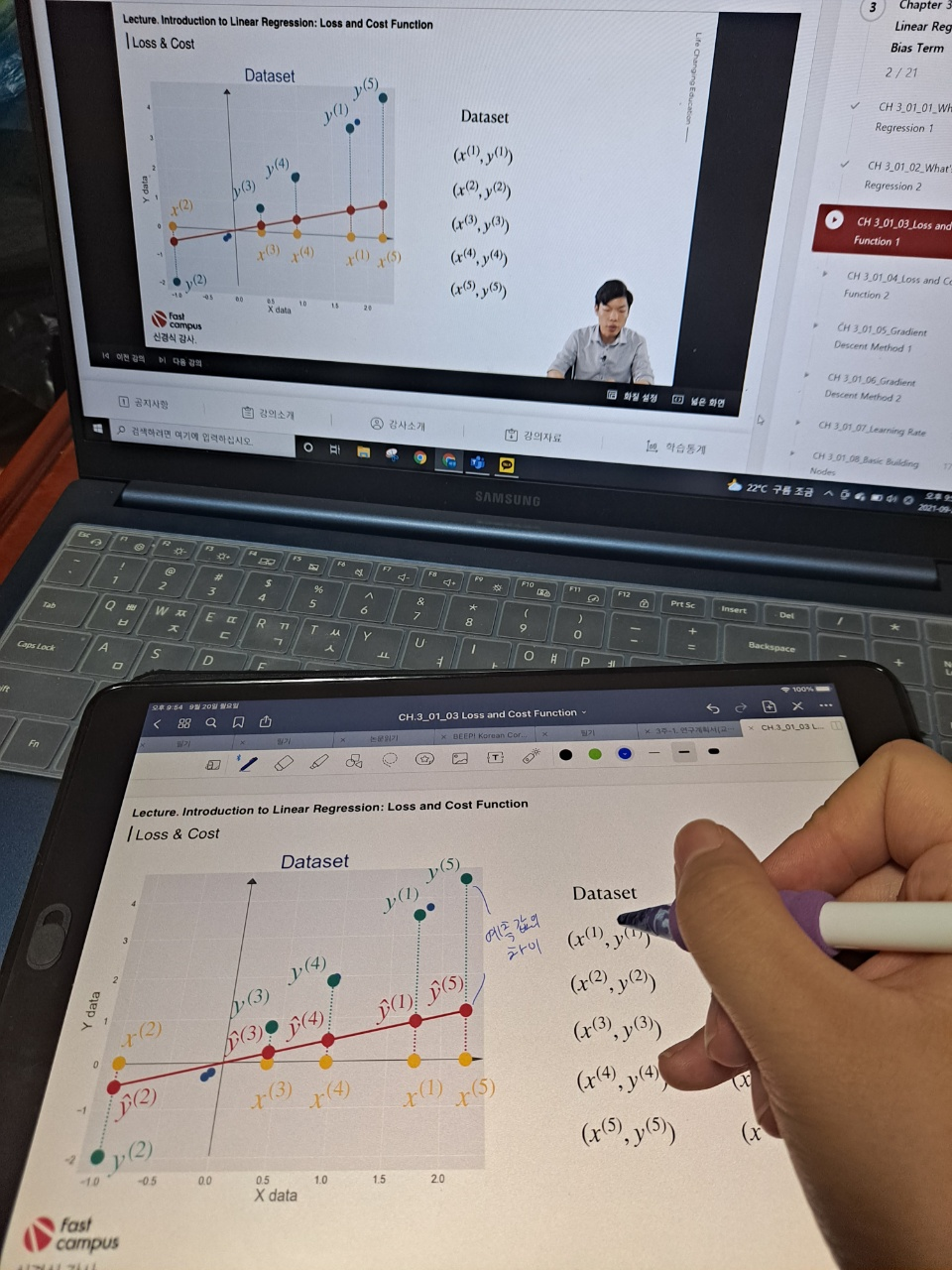

3-1-3 Loss and Cost Function 1

2주간 습관을 쌓아와서인지 추석에도 빠지지 않고 공부했다.

오늘의 강의는 궁금했던 loss와 cost의 차이였다.

loss는 <예측값과 실제값의 차이>이고, cost는 예측값과 실제값들의 차이를 데이터 수만큼 나눈 것, 즉, <loss의 평균>이라고 보면 된다.

그동안 딥러닝을 공부해왔기 때문에 prediction과 true 값의 차이는 많이 배워왔고, cost function과 loss function에 대해서 많이 듣고, 배우고, 활용까지 해봤었다.

그런데 이렇게 다시 글로써 정리해주시니 머릿속에서 어렴풋한 것들이 잘 정리가 된 것 같다.

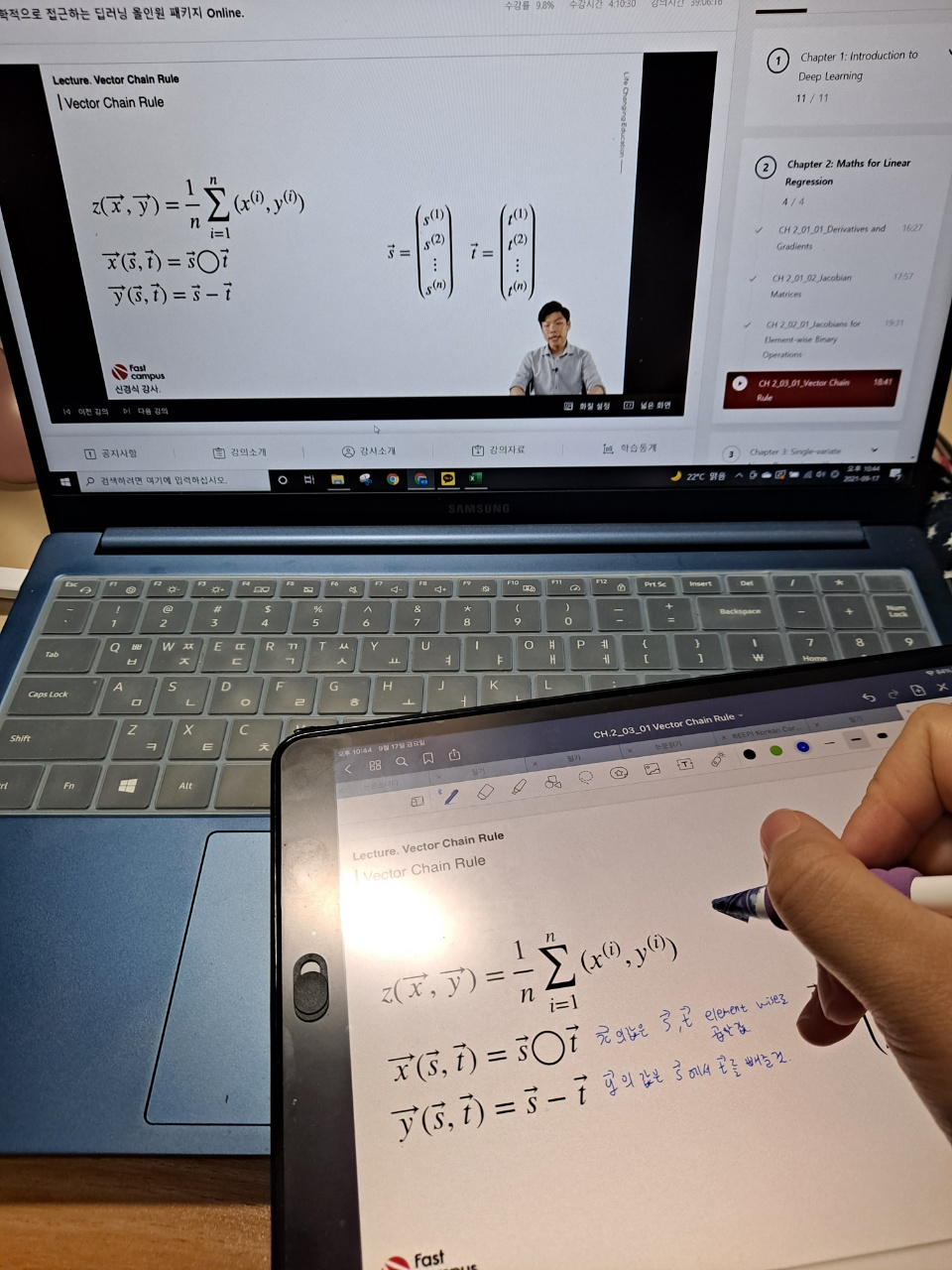

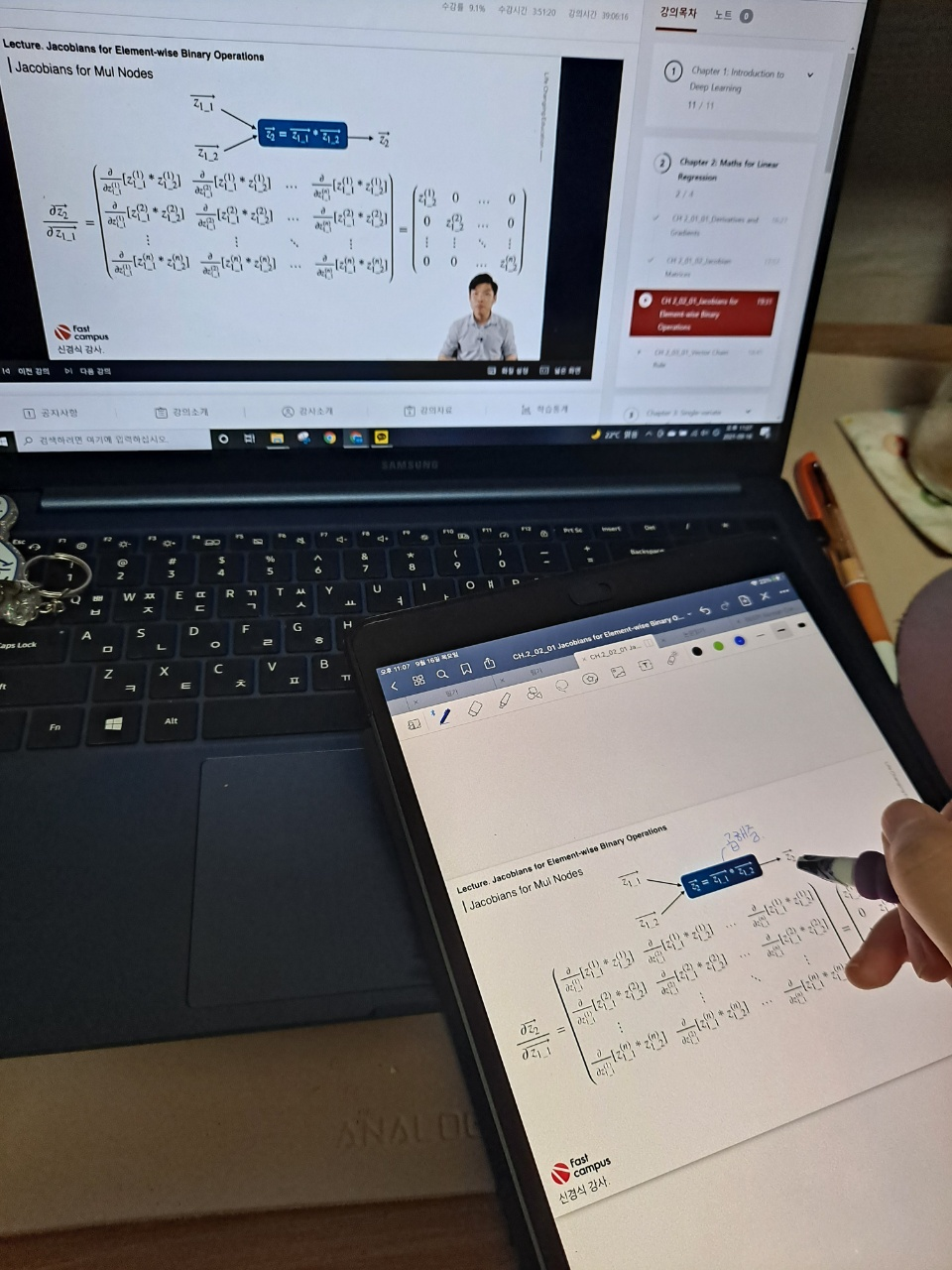

그동안의 강의와 패캠의 차이점은 디테일에서 나오는 것 같다.

(무료강의였지만..) 전에 들었던 강의들은 예시를 많이 들어주지 않아서 여러 글들을 많이 찾아보면서 이런예시 저런예시를 직접 찾아보며 이해했다. (마치 딥러닝에서도 데이터가 많아야 일반화가 쉽게 되는것 처럼 많은 예시를 찾았다.)

그런데 이 패캠 딥러닝 강의에서는 예시를 많이, 그리고 세세히 설명을 해주셔서 더 이해가 잘 된 것 같다.

오늘은 음식 준비의 날이었지만, 내일은 차례를 지내고 시골을 갔다오고해서 출석을 잘 할 수 있을지 모르겠다..

그렇지만 2주간 쌓아올려놓은 습관을 무너뜨릴 순 없으니 열심히 다짐해야지!! 화이팅!

내일 강의도 loss와 cost관련 강의인데, 내가 모르는 것 중 어떤 것이 나올지 기대된다.

▼패캠 강의 리스트▼

*본 포스팅은 패스트캠퍼스 환급 챌린지 참여를 위해 작성되었습니다.*

#패스트캠퍼스, #패캠챌린지 #직장인인강 #직장인자기계발 #패스트캠퍼스후기 #수학적으로_접근하는_딥러닝_올인원_패키지_Online #대학원생공부 #인공지능독학 #머신러닝 #딥러닝

'인공지능 > 수학' 카테고리의 다른 글

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 17일차 (0) | 2021.09.22 |

|---|---|

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 16일차 (0) | 2021.09.21 |

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 14일차 (0) | 2021.09.19 |

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 13일차 (0) | 2021.09.18 |

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 12일차 (0) | 2021.09.17 |