2021.10.03 일요일 28일차

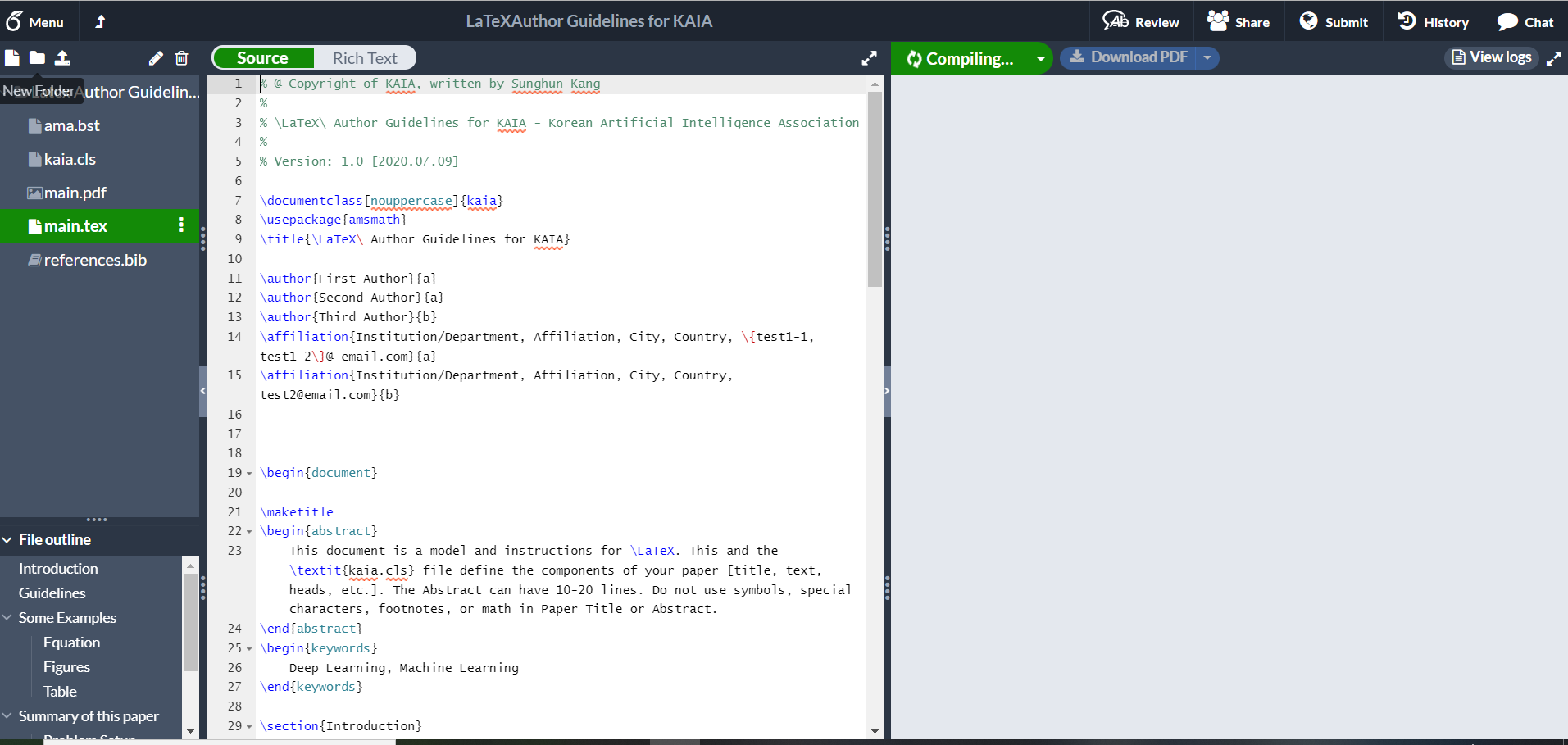

3-5-2 for Several Samples - Backpropagation with NumPy 2

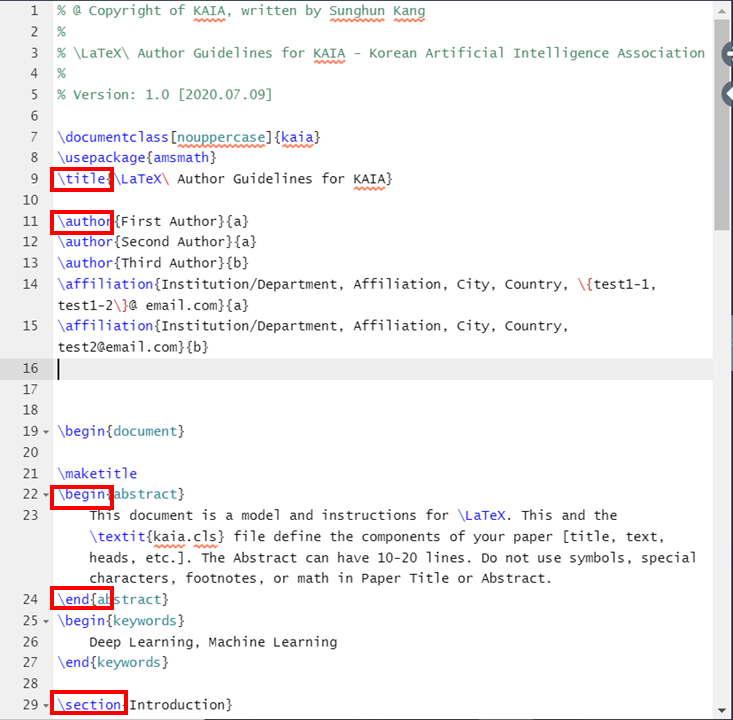

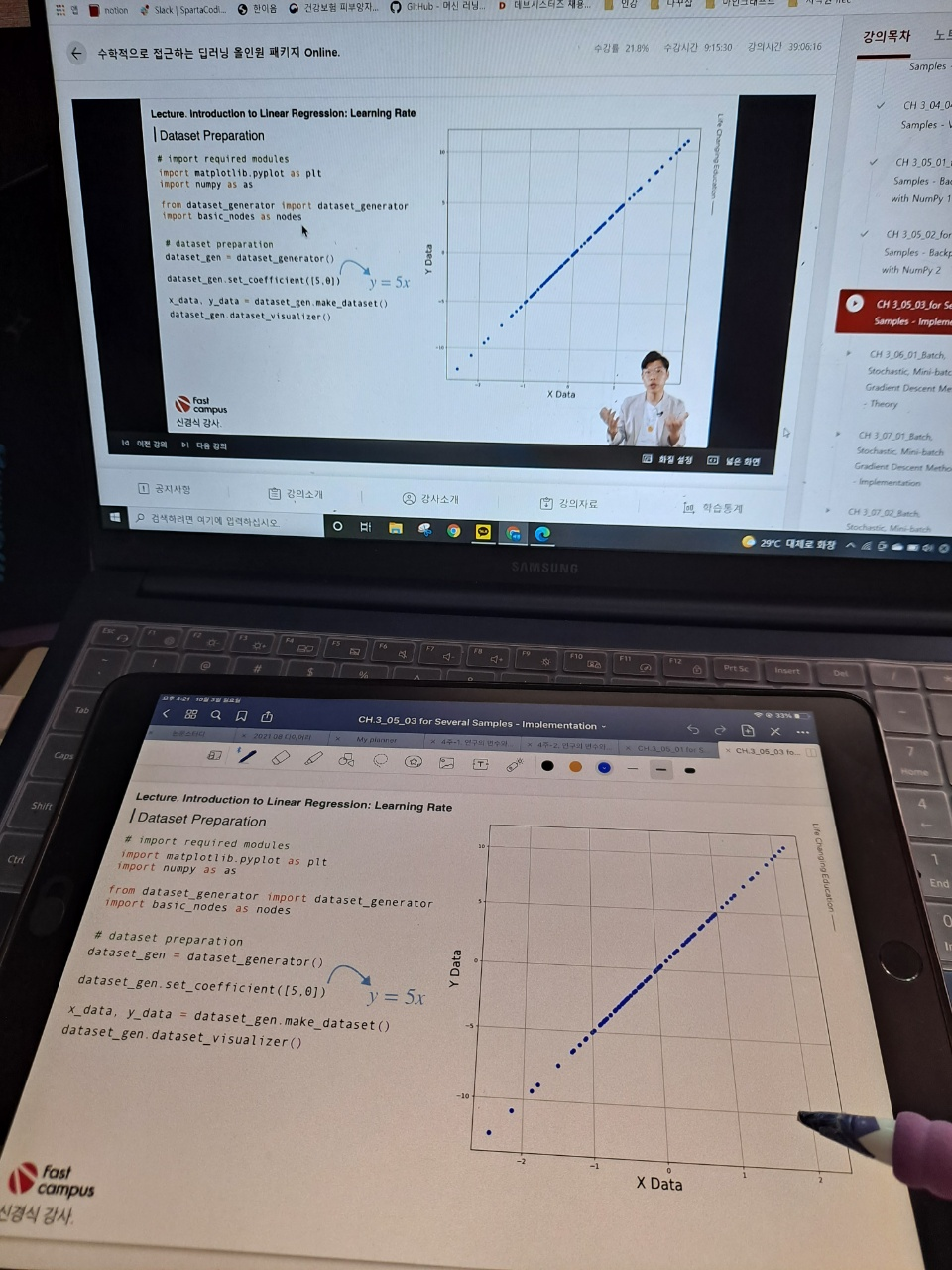

3-5-3 for Several Samples - Implementation

이제 챕터 3이 얼마나 남지 않았다! 3강이 남았다. 환급반 챌린지는 이틀 남았으니 챌린지동안 챕터 3은 끝낼 수 있겠다.

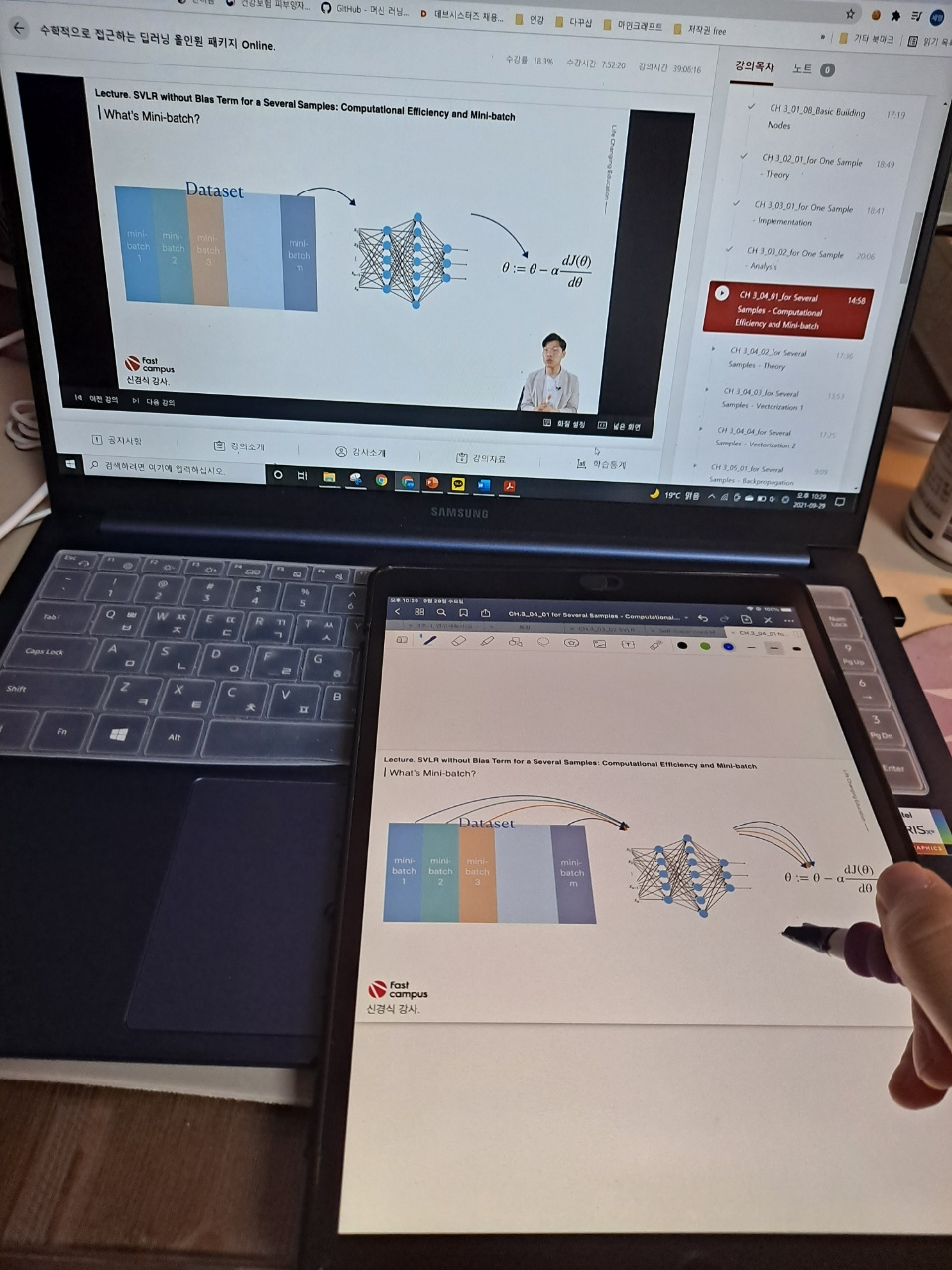

오늘의 강의는 지난 시간에 이어 여러 개의 샘플에 대한 BackPropagation과 코드로 구현하는 것에 대해서 배웠다.

오늘은 어제(이전 강의에서) 자세히 배우지 못한 BackPropagation의 수식이 전개되는 과정을 자세히 배웠다.

사실 앞에 것들을 배우면서 까먹은 부분도 많고, 이해를 아직 다 못 한 부분이 많아서 어떤 부분이 수식 전개에서 어떻게 드러나는지는 잘 파악하지 못했다.

그렇지만 다시 들을 생각으로 겉핥기다 생각하고 열심히 들었다.

수식전개로 어디서 backpropagation이 진행되고, backward는 어떻게 되고 forward는 어떻게 되고 그런 것들을 중심으로 크게크게 보며 들었다.

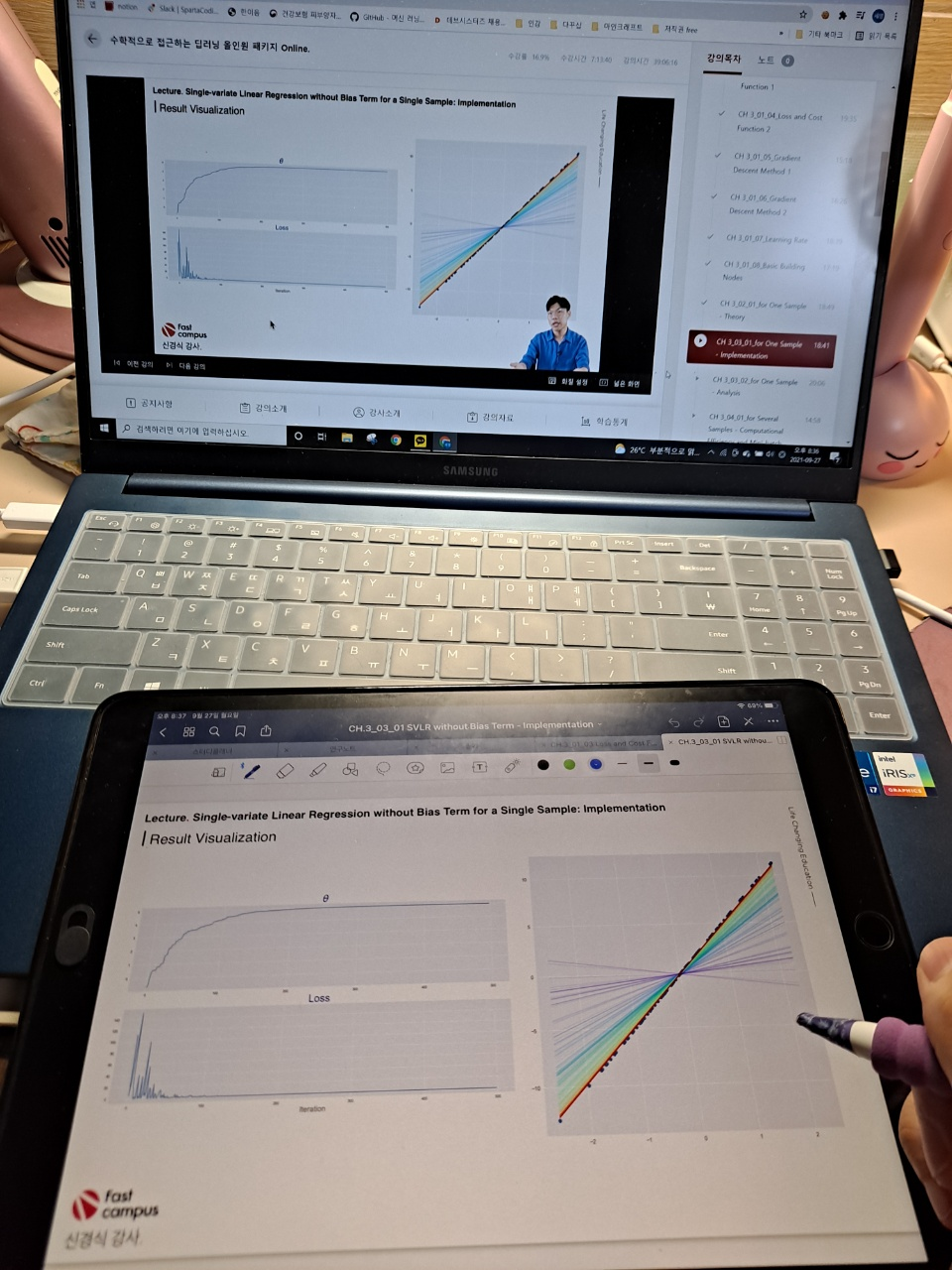

그리고 Implementation. 구현 부분으로 넘어왔다.

앞에 이론적인 부분도 크게크게만 들어서 정확히 어떻게 진행되는 것인지는 잘 이해하지 못했지만 여기에서도 코드가 어떻게 쓰이고 그런지를 알아보기 위해 열심히 들었다.

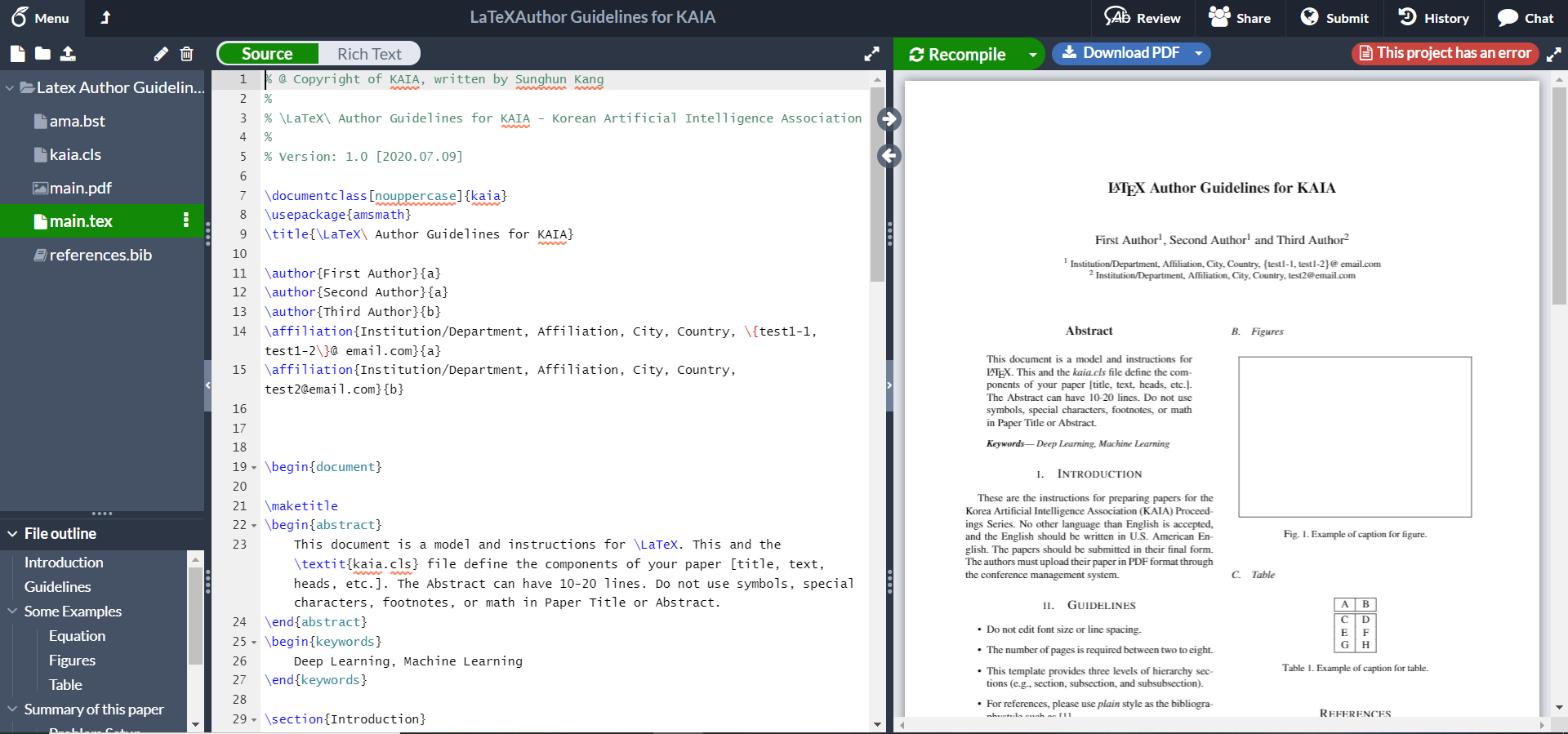

내가 이해를 다 못해서 그런건지는 잘 모르겠지만, 이론 부분의 설명과 크게 다를 것은 없었고, 코드로 구현을 하니 결과를 눈으로 확인할 수 있다는 점이 달랐다.

loss나 θ의 변화를 그래프나 값으로 확인해볼 수 있어서 이해가 조금 더 쉬웠다는 점이 달랐다.

이번 환급반 챌린지가 끝나면 챕터 3은 다시 복습해야할 것 같다. 일단 챕터3을 다 들어야지..

▼패캠 강의 리스트▼

*본 포스팅은 패스트캠퍼스 환급 챌린지 참여를 위해 작성되었습니다.*

#패스트캠퍼스, #패캠챌린지 #직장인인강 #직장인자기계발 #패스트캠퍼스후기 #수학적으로_접근하는_딥러닝_올인원_패키지_Online #대학원생공부 #인공지능독학 #머신러닝 #딥러닝

'인공지능 > 수학' 카테고리의 다른 글

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 30일차 (0) | 2021.10.05 |

|---|---|

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 29일차 (0) | 2021.10.04 |

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 27일차 (0) | 2021.10.02 |

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 26일차 (0) | 2021.10.01 |

| [패캠환급반] 딥러닝 인강 100% 환급 패스트캠퍼스 챌린지 25일차 (0) | 2021.09.30 |